OpenAI ogłosiło niedawno swój model GPT-4o, nowy flagowy model silnika obsługującego ChatGPT, jego słynny chatbot oparty na sztucznej inteligencji, wydany po raz pierwszy w 2022 roku. Ten nowszy model przenosi interakcję człowiek-komputer na zupełnie nowy poziom, sprawiając, że wydaje się ona szybsza i o wiele bardziej naturalny.

W GPT-4o „o” oznacza „omni”, ponieważ łączy tekst, obraz i dźwięk w jeden model. Chociaż nie ma poprawy w zakresie inteligencji i rozumowania w porównaniu z modelem GPT-4 Turbo, istnieje wiele nowych aktualizacji. Został zaprojektowany tak, aby zapewniać szybsze, bardziej ludzkie reakcje, a nawet może symulować emocje. Znacznie szybciej rozumie także sygnały wizualne i dźwiękowe. Podczas tej szczegółowej analizy przyjrzymy się funkcjom, jakie oferuje GPT-4o i temu, jak zrewolucjonizuje sposób interakcji z asystentami AI. Dołącz do nas i zaczynajmy!

GPT-4o jest znacznie szybszy

Model GPT-4o umożliwia ChatGPT akceptowanie danych wejściowych w różnych formach, w tym audio, tekstowych, obrazów lub ich kombinacji. Może także dostarczać odpowiedzi w różnych formatach. Jednak najbardziej imponująca jest szybkość, z jaką dostarcza odpowiedzi.

W nowym modelu ChatGPT potrzebuje zaledwie około 320 milisekund, aby odpowiedzieć na sygnały audio, czyli mniej więcej tyle, ile potrzebuje osoba, aby odpowiedzieć w trakcie rozmowy. Poza tym wydajność GPT-4o jest podobna do GPT-4 Turbo, jeśli chodzi o użycie języka angielskiego lub pisanie kodu.

Działa również znacznie lepiej, odpowiadając na dane wejściowe w językach innych niż angielski i jest znacznie tańszy w interfejsie API, ponieważ jest znacznie wydajniejszy niż jego poprzednik.

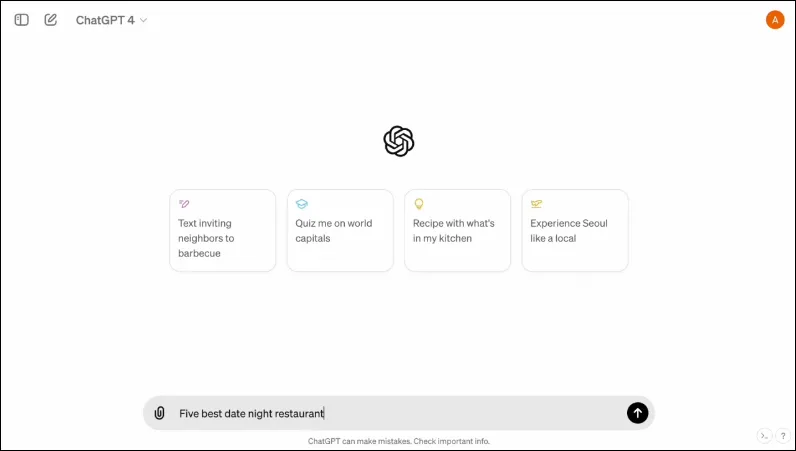

Posiada również nowy interfejs, zaprojektowany tak, aby interakcja była łatwiejsza i bardziej uporządkowana.

Jest multimodalny

Istniejący tryb głosowy ChatGPT składa się z trzech modeli. Pierwszy pobiera dane wejściowe w formacie tekstowym i zapewnia wyjście w tym samym formacie, podczas gdy drugi konwertuje wejście audio na tekst, który jest pobierany przez ChatGPT w celu zapewnienia wyjścia tekstowego. Ostatni model konwertuje tekst na dźwięk.

Jednak taki projekt powoduje utratę informacji, ponieważ model nie może bezpośrednio wchodzić w interakcję z wejściem audio lub obecnym wyjściem, które zawiera elementy emocjonalne. Dzięki GPT-4o OpenAI zbudowało pojedynczy model multimodalny, który może zrozumieć różne typy danych wejściowych i bezpośrednio przetwarzać wymagane dane wyjściowe.

Obecnie obsługuje 50 języków i będzie również dostępny jako API.

Może symulować ludzkie emocje

Kiedy po raz pierwszy ogłoszono ChatGPT, dla wielu osób jedną z największych wad chatbota AI był brak możliwości wywoływania reakcji emocjonalnych. Dzięki GPT-4o ChatGPT może symulować ludzkie emocje i zapewniać odpowiednie reakcje, które integrują te emocje.

W demonstracjach udostępnianych przez OpenAI chatbota można zobaczyć śmiejącego się, śpiewającego, a nawet okazującego sarkazm, gdy zostanie o to poproszony. To o wiele więcej niż jakikolwiek inny chatbot AI, który obecnie może zrobić i sprawi, że interakcje z użytkownikiem będą znacznie przyjemniejsze. Według OpenAI nowy model pozwoli ChatGPT również wykrywać nastroje użytkowników i na ich podstawie udzielać odpowiednich odpowiedzi.

W połączeniu z możliwością korzystania z sygnałów wizualnych, możliwość wywoływania reakcji emocjonalnych to jedna z najbardziej imponujących funkcji, jakie oferuje nowy model.

Nowy model może przechowywać większą ilość informacji

Dzięki GPT-4o ChatGPT może teraz lepiej rozumieć obrazy, takie jak wykresy i zdjęcia, a także przechowywać więcej informacji o użytkowniku. Przekłada się to również na odpowiedzi, które mogą zawierać większe fragmenty tekstu, co może być przydatne w kilku przypadkach użycia.

Na przykład możesz teraz poprosić chatbota o przetłumaczenie większych fragmentów tekstu, co pomoże Ci w tłumaczeniu na żywo. Ponieważ może wykorzystywać dane wejściowe wizualne i dźwiękowe wraz z wejściami tekstowymi, można go używać do zbierania informacji ze zrzutów ekranu, zdjęć i innych obrazów.

Ponieważ może przechowywać większą ilość informacji bez konieczności ich powtarzania przez użytkowników, GPT-4o umożliwia użytkownikom uczestniczenie w ciągłych rozmowach z chatbotem AI. Dzięki większej ilości informacji użytkownicy mogą oczekiwać, że rozmowy będą bardziej zaawansowane.

Zabezpieczenia w Nowym Modelu

Podobnie jak istniejące modele GPT, GPT-4o zaprojektowano z uwzględnieniem pewnych zabezpieczeń zapewniających bezpieczeństwo. Dane treningowe zostały przefiltrowane, a zachowanie modelu zostało udoskonalone po treningu. OpenAI oceniło również model sztucznej inteligencji pod kątem kilku parametrów, takich jak cyberbezpieczeństwo i perswazja, aby uniknąć niepożądanych incydentów.

Poza tym twórcy skorzystali z pomocy ponad 70 ekspertów z różnych dziedzin, takich jak dezinformacja i psychologia społeczna, aby zidentyfikować i złagodzić ryzyko, które może wystąpić lub wzrosnąć w przypadku nowego modelu. Będą również w dalszym ciągu monitorować korzystanie z chatbota pod kątem przyszłych zagrożeń i podejmować wymagane działania w razie potrzeby.

Na początek OpenAI udostępni jedynie ograniczony wybór gotowych ustawień modelu głosu. Uwzględni także uwagi przekazane przez użytkowników, aby ulepszyć model i zapewnić pełne bezpieczeństwo.

Dostępność GPT-4o

Do tej pory dostępne były dwie wersje ChatGPT – darmowa wersja działająca na GPT 3.5 i płatna wersja działająca na GPT 4.0 i kosztująca 20 dolarów miesięcznie. Ten ostatni może uzyskać dostęp do większego modelu językowego, co pozwala na obsługę większej ilości danych.

GPT-4o będzie dostępny zarówno dla użytkowników bezpłatnych, jak i płatnych, a jego wprowadzenie na urządzenia ma nastąpić w nadchodzących tygodniach. Będzie ona dostępna na urządzeniach mobilnych za pośrednictwem istniejącej aplikacji, która będzie aktualizowana. Oprócz wersji internetowej dla użytkowników komputerów stacjonarnych dostępna będzie także nowa aplikacja komputerowa na macOS (wersja dla systemu Windows pojawi się jeszcze w tym roku).

Aby rozróżnić użytkowników bezpłatnych i płatnych, OpenAI zaoferuje użytkownikom płatnym pięciokrotnie większą pojemność niż użytkownikom darmowym. Po wyczerpaniu limitu nastąpi powrót do ChatGPT 3.5.

Ogłoszenie OpenAI dotyczące GPT-40 następuje zaledwie dzień przed doroczną konferencją Google dla programistów I/O, podczas której Google ma ogłosić własne ogłoszenia związane ze sztuczną inteligencją. OpenAI obiecało również, że wkrótce pojawi się więcej ogłoszeń, więc nie ma wątpliwości, że rywalizacja między dwoma rywalami dopiero zaczyna się zaostrzać.

Chociaż nie wiemy, kiedy OpenAI zaprezentuje więcej zmian w swoim modelu AI, wiemy, że GPT-4o zmierza na całym świecie do urządzeń z systemem ChatGPT. Trzymajcie zatem kciuki i czekajcie, aż aktualizacja pojawi się na Waszym urządzeniu. Do następnego razu!

Dodaj komentarz