Podczas corocznej konferencji I/O w Kalifornii Google ogłosił kilka ogłoszeń związanych ze sztuczną inteligencją, w tym nowych modeli i ulepszeń istniejących. Jedną z najciekawszych zapowiedzi był Project Astra – multimodalny asystent działający w czasie rzeczywistym i łączący możliwości Google Lens i Gemini, aby dostarczać Ci informacji z Twojego otoczenia.

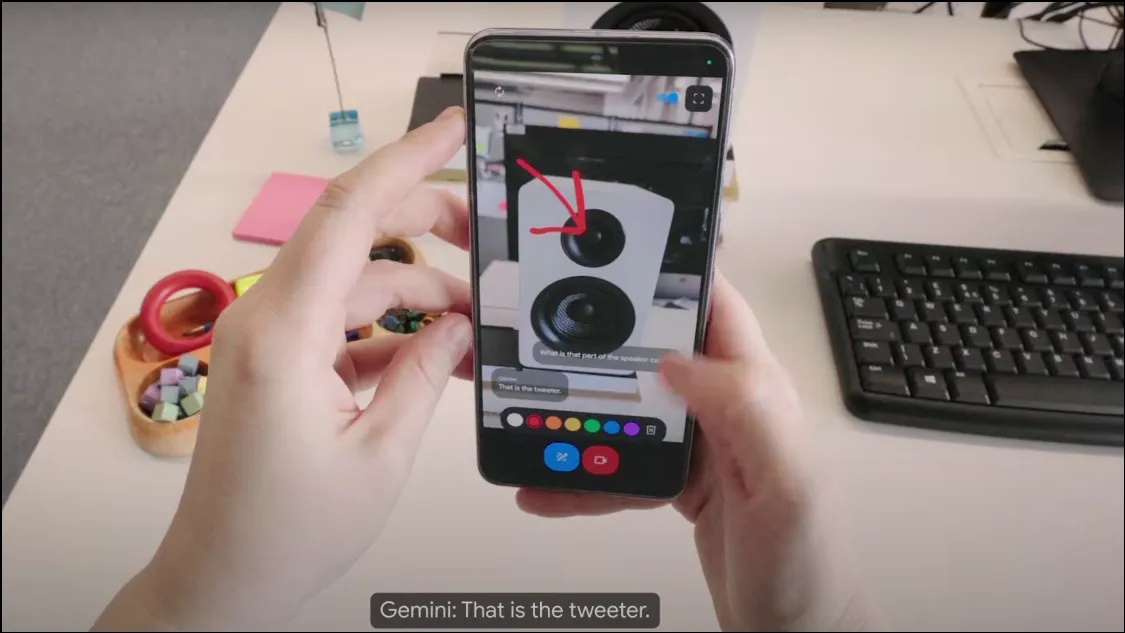

Jak działa Projekt Astra? Na konferencji Google zaprezentowało wczesną wersję Project Astra, która działa jako chatbot oparty na kamerze i może zbierać informacje z otoczenia za pomocą kamery w Twoim urządzeniu. Będąc multimodalnym asystentem AI, może wykorzystywać dźwięk, wideo i obrazy jako dane wejściowe i na ich podstawie zapewniać niezbędne dane wyjściowe. Działa na modelu Gemini 1.5 Pro, co czyni go niesamowicie wydajnym.

Chatbot analizuje obiekty i otoczenie w czasie rzeczywistym i może bardzo szybko odpowiadać na zapytania, dzięki czemu jest dość podobny do ludzkiego asystenta, czy ukochanego JARVISA Tony’ego Starka. Project Astra współpracuje również z urządzeniami do noszenia, takimi jak inteligentne okulary, co oznacza, że chatbot AI ma duży potencjał integracji z różnymi urządzeniami.

Project Astra może lepiej zrozumieć kontekst, w którym jest używany, szybciej przetwarzać informacje i zachowywać je w celu szybszego przywołania. Jego możliwości mowy są również znacznie ulepszone w porównaniu z wcześniejszymi modelami Gemini, dzięki czemu brzmi bardziej naturalnie i ludzki.

Co potrafi Projekt Astra? W krótkim pokazie pokazanym przez Google wydaje się, że Project Astra może pomóc w wielu osiągnięciach. Może obserwować i rozumieć obiekty i lokalizacje za pomocą obiektywu kamery i mikrofonu oraz dostarczać informacji na ich temat. Możesz na przykład po prostu skierować telefon na fragment kodu i omówić go z chatbotem lub poprosić go o zidentyfikowanie obiektu i jego zastosowania.

Podobnie, dzięki funkcjom rozpoznawania lokalizacji, Project Astra może dostarczyć informacji o Twojej okolicy, po prostu patrząc na otoczenie. Może także zachować wyświetlane mu informacje, co może być bardzo przydatne, jeśli chcesz zlokalizować zagubione przedmioty, jak pokazano w wersji demonstracyjnej, która pomogła użytkownikowi znaleźć okulary.

Możesz także poprosić asystenta AI o kreatywne pomysły, tak jak w przypadku Gemini w telefonie. Możesz na przykład poprosić go o wymyślenie tekstu piosenki, nazwy zespołu muzycznego lub czegokolwiek innego. Zasadniczo Project Astra ma być uniwersalnym asystentem AI, który może dostarczać informacji w czasie rzeczywistym w bardzo konwersacyjny sposób.

Kiedy będzie dostępny Project Astra? Na razie Google nie ogłosiło dostępności Project Astra. Wersja pokazana w wersji demonstracyjnej jest wczesnym prototypem, ale Google zasugerował, że te funkcje mogą zostać zintegrowane z istniejącą aplikacją Gemini na późniejszym etapie.

Dzięki Project Astra Google stara się przewodzić ewolucji asystentów AI, aby stali się jeszcze bardziej użyteczni i łatwiejsi w użyciu. Jednak Google nie jest jedynym, który dąży do tego celu. OpenAI ogłosiło również niedawno GPT-4o, czyniąc ChatGPT multimodalnym, zwiększając jego możliwości i wydajność. Nowy tryb głosowy ChatGPT (który zostanie wkrótce udostępniony) może także wykorzystywać sygnał wideo z kamery urządzenia podczas interakcji z użytkownikami.

W tej chwili różnica między nimi polega na tym, że GPT-4o będzie wkrótce dostępny na wszystkich urządzeniach z uruchomionym ChatGPT, podczas gdy Project Astra ma być dostępny w przyszłości jako Gemini Live, chociaż obecnie nie jest znana data premiery. Ponieważ ChatGPT zasilany GPT-4o będzie dostępny wcześniej, okaże się, czy Google Project Astra będzie wystarczająco dobry, aby konkurować z bardziej popularnym chatbotem OpenAI.

Dodaj komentarz