Jeśli chcesz uruchomić Large Language Models lub LLM na swoim komputerze, jednym z najłatwiejszych sposobów jest Ollama. Ollama to potężna platforma open-source, która oferuje konfigurowalne i łatwo dostępne środowisko AI. Ułatwia pobieranie, instalowanie i interakcję z różnymi LLM, bez konieczności polegania na platformach w chmurze lub bez konieczności posiadania jakiejkolwiek wiedzy technicznej.

Oprócz powyższych zalet, Ollama jest dość lekka i regularnie aktualizowana, co czyni ją całkiem odpowiednią do budowania i zarządzania LLM na maszynach lokalnych. Dzięki temu nie potrzebujesz żadnych zewnętrznych serwerów ani skomplikowanych konfiguracji. Ollama obsługuje również wiele systemów operacyjnych, w tym Windows, Linux i macOS, a także różne środowiska Docker.

Pobieranie i instalowanie Ollama

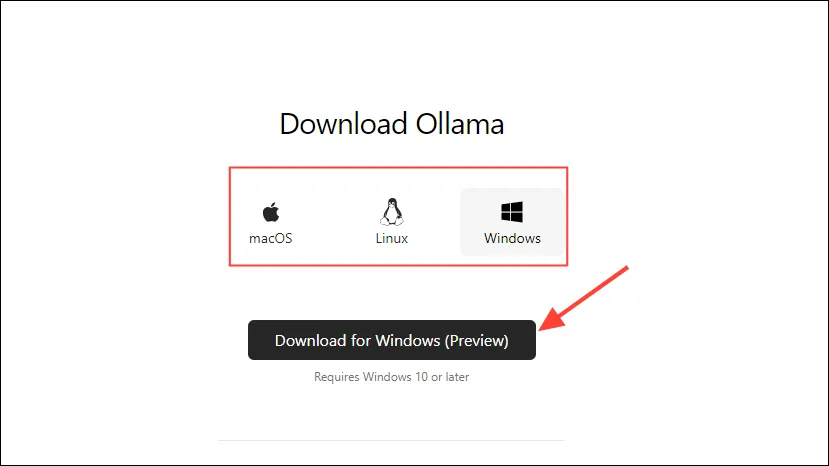

- Najpierw wejdź na stronę pobierania Ollama i wybierz swój system operacyjny, zanim klikniesz przycisk „Pobierz”.

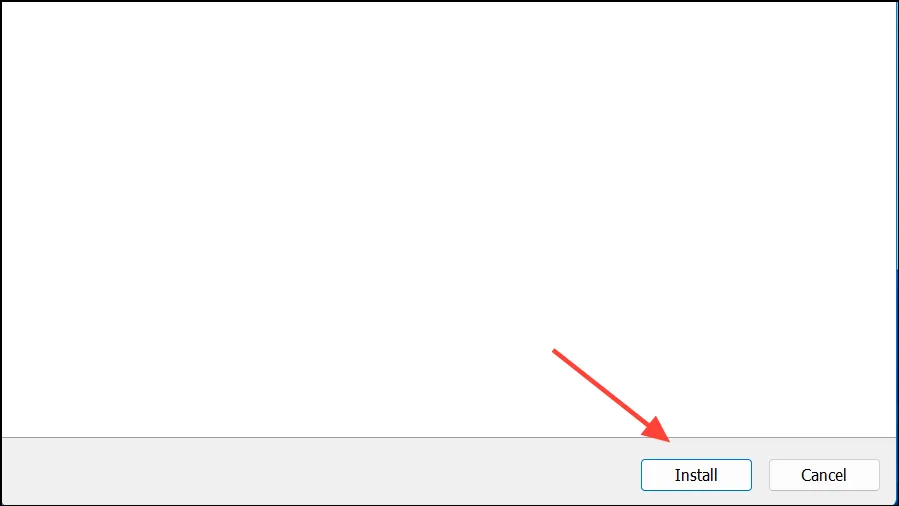

- Po zakończeniu pobierania otwórz go i zainstaluj na swoim komputerze. Instalator zamknie się automatycznie po zakończeniu instalacji.

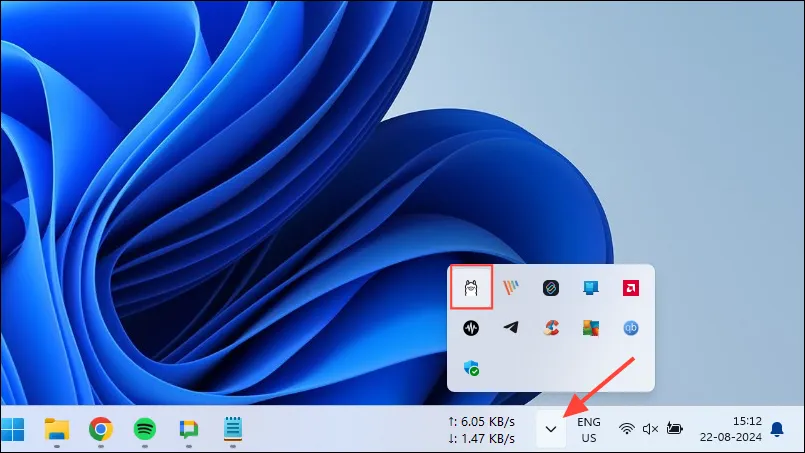

- W systemie Windows możesz sprawdzić, czy Ollama jest uruchomiona, czy nie, klikając przycisk przepełnienia paska zadań, aby wyświetlić ukryte ikony.

Dostosowywanie i używanie Ollama

Po zainstalowaniu Ollama na komputerze pierwszą rzeczą, którą powinieneś zrobić, jest zmiana miejsca przechowywania danych. Domyślnie jest to lokalizacja przechowywania, C:\Users\%username%\.ollama\modelsale ponieważ modele AI mogą być dość duże, dysk C może szybko się zapełnić. Aby to zrobić,

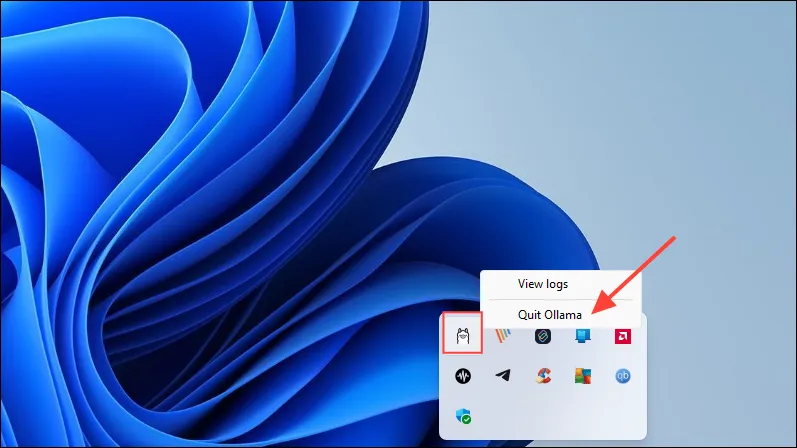

- Najpierw kliknij ikonę Ollama na pasku zadań i kliknij „Zamknij Ollamę”.

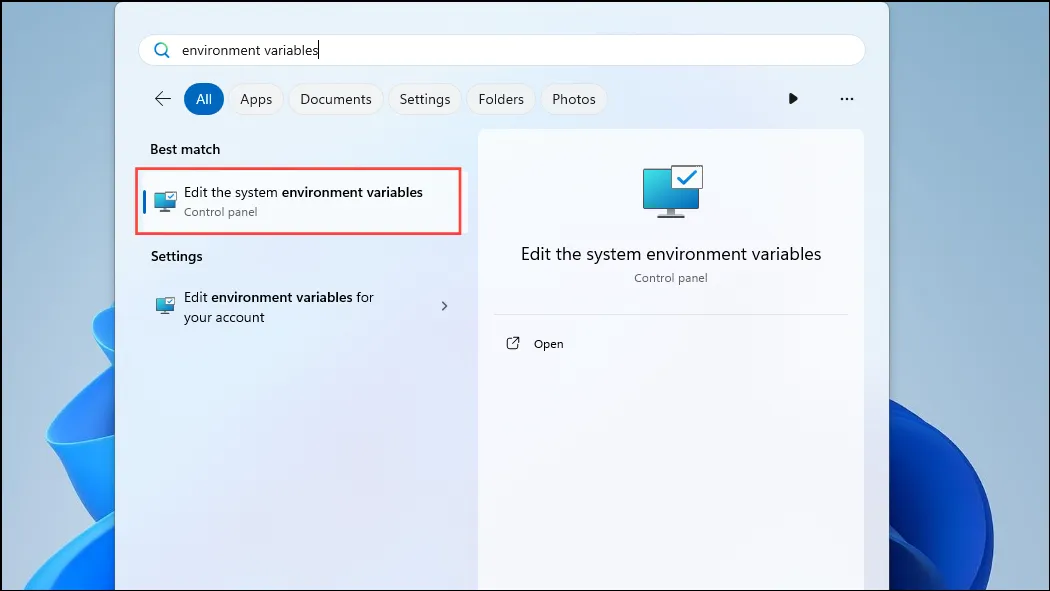

- Po zamknięciu Ollama otwórz menu Start, wpisz

environment variablesi kliknij „Edytuj zmienne środowiskowe systemu”.

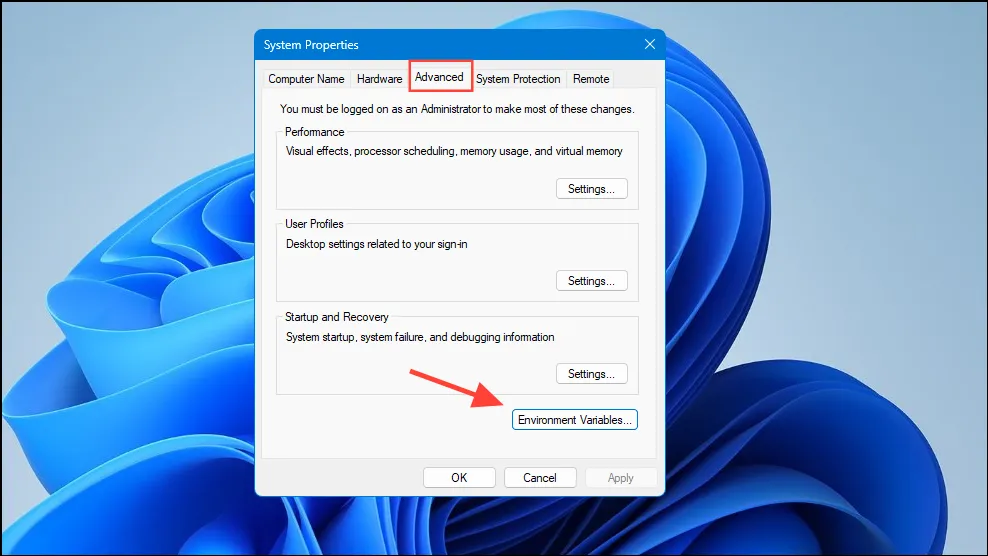

- Gdy otworzy się okno dialogowe Zmienne systemowe, kliknij przycisk „Zmienne środowiskowe” na karcie „Zaawansowane”.

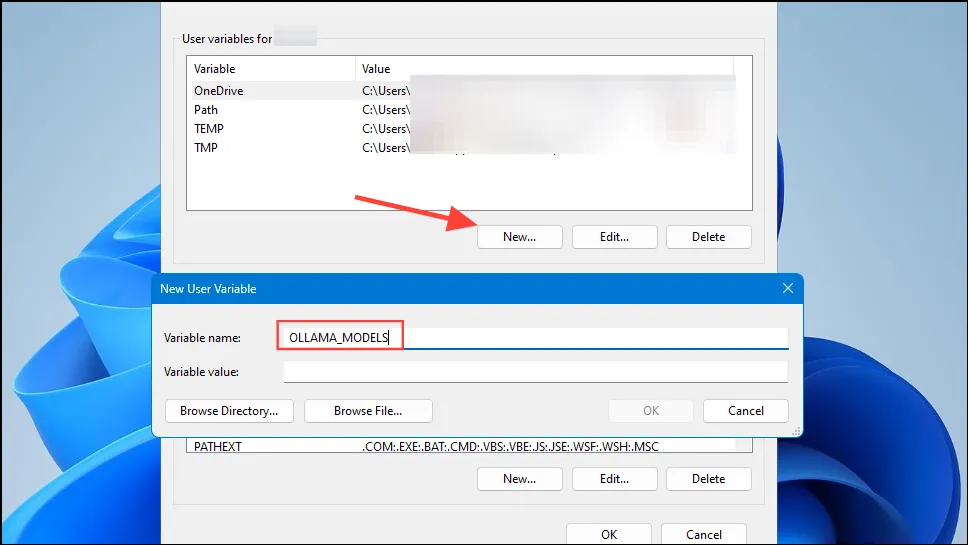

- Kliknij przycisk „Nowy” dla swojego konta użytkownika i utwórz zmienną o nazwie

OLLAMA_MODELSw polu „Nazwa zmiennej”.

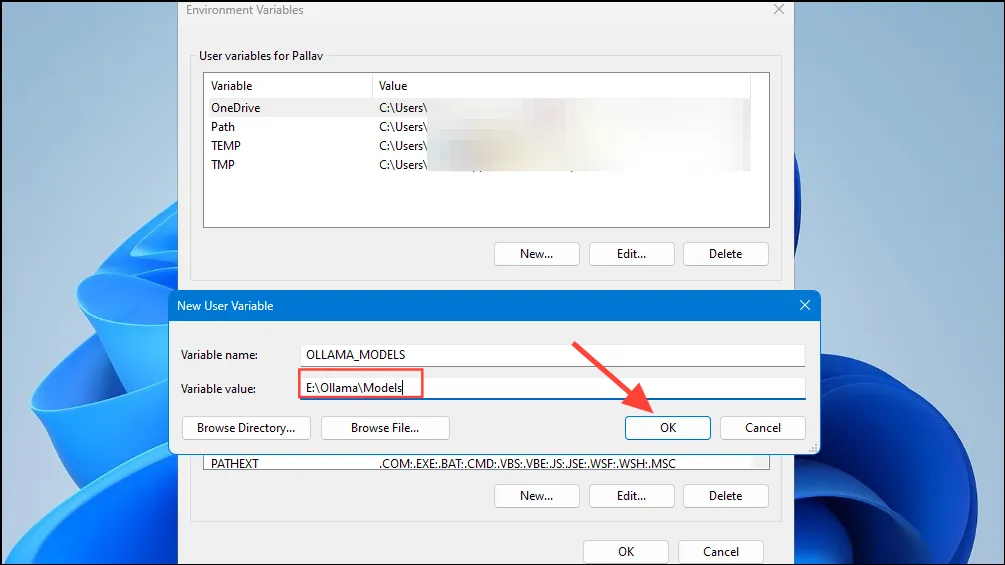

- Następnie wpisz lokalizację katalogu, w którym Ollama ma przechowywać swoje modele w polu „Wartość zmiennej”. Następnie kliknij przycisk „OK” przed uruchomieniem Ollama z menu Start.

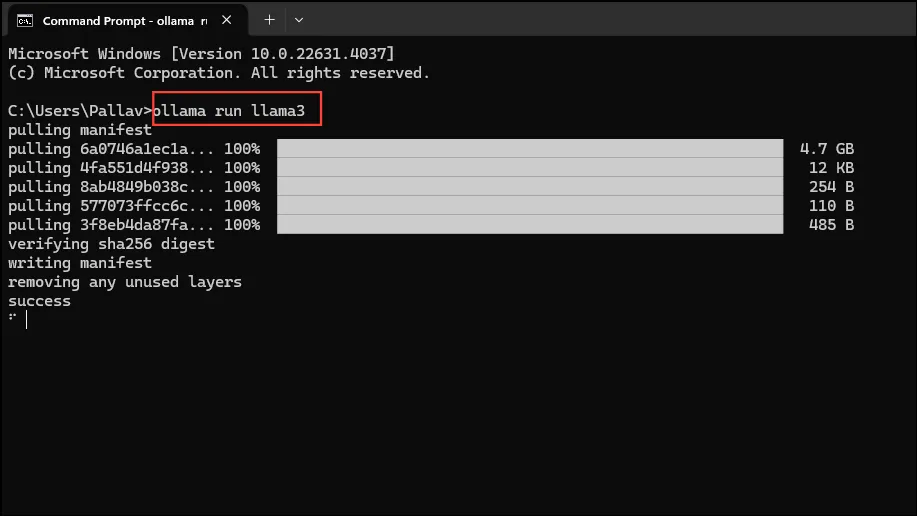

- Teraz jesteś gotowy, aby zacząć używać Ollama, a możesz to zrobić za pomocą Meta’s Llama 3 8B, najnowszego modelu AI typu open source firmy. Aby uruchomić model, uruchom wiersz poleceń, Powershell lub okno terminala Windows z menu Start.

- Gdy otworzy się okno wiersza poleceń, wpisz

ollama run llama3i naciśnij Enter. Model ma prawie 5 GB, więc pobranie go zajmie trochę czasu.

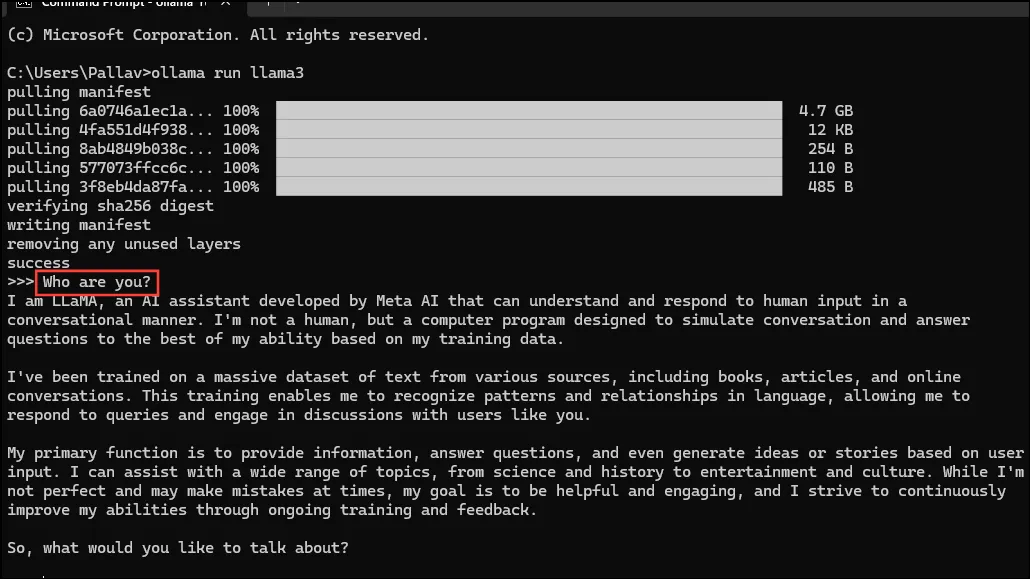

- Po zakończeniu pobierania możesz zacząć używać Llama 3 8B i rozmawiać z nim bezpośrednio w oknie wiersza poleceń. Na przykład możesz zapytać model

Who are you?i nacisnąć Enter, aby uzyskać odpowiedź.

- Teraz możesz kontynuować rozmowę i zadawać modelom AI pytania na różne tematy. Pamiętaj tylko, że Llama 3 może popełniać błędy i mieć halucynacje, więc powinieneś być ostrożny podczas korzystania z niej.

- Możesz również wypróbować inne modele, odwiedzając stronę biblioteki modeli Ollama. Ponadto istnieją różne polecenia, które możesz uruchomić, aby wypróbować różne funkcjonalności oferowane przez Ollama.

- Podczas działania modelu można także wykonywać różne operacje, takie jak ustawianie zmiennych sesji, wyświetlanie informacji o modelu, zapisywanie sesji i wiele innych.

- Ollama pozwala również korzystać z multimodalnych modeli AI do rozpoznawania obrazów. Na przykład model LLava może rozpoznawać obrazy generowane przez DALLE-3. Może szczegółowo opisywać obrazy.

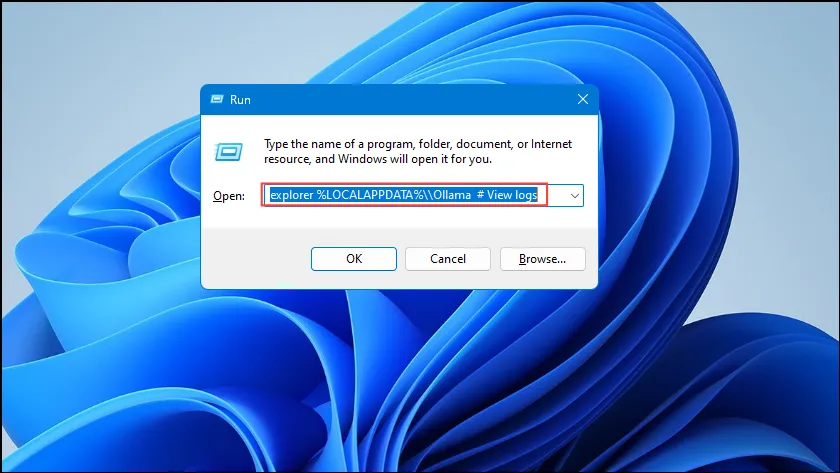

- Jeśli podczas uruchamiania Ollama napotykasz błędy, możesz sprawdzić dzienniki, aby dowiedzieć się, co jest problemem. Użyj skrótu,

Win + Raby otworzyć okno dialogowe Uruchom, a następnie wpiszexplorer %LOCALAPPDATA%\\Ollama # View logsw nim tekst przed naciśnięciem Enter.

- Można również użyć innych poleceń, takich jak

explorer %LOCALAPPDATA%\\Programs\\Ollamai ,explorer %HOMEPATH%\\.ollamaaby sprawdzić lokalizację przechowywania plików binarnych, modelu i konfiguracji.

Rzeczy, które warto wiedzieć

- Ollama automatycznie wykrywa Twój GPU, aby uruchomić modele AI, ale w maszynach z wieloma GPU może wybrać niewłaściwy. Aby tego uniknąć, otwórz Panel sterowania Nvidia i ustaw Wyświetlacz na „Tylko GPU Nvidia”.

- Tryb wyświetlania może nie być dostępny na każdym komputerze i nie pojawia się również po podłączeniu komputera do zewnętrznych wyświetlaczy.

- W systemie Windows możesz sprawdzić, czy Ollama używa właściwego procesora graficznego, korzystając z Menedżera zadań. Wyświetli on użycie procesora graficznego i poinformuje, który procesor jest używany.

- Chociaż instalacja Ollama w systemach macOS i Linux nieco różni się od instalacji w systemie Windows, proces uruchamiania LLM za jej pomocą jest dość podobny.

Dodaj komentarz