Kolejny model AI dołączył do morza modeli AI i jest to ponownie OpenAI. OpenAI wydało wcześniej GPT-4o w tym roku, który miał być bardziej wydajny niż GPT-4. Ale nadal był dość drogi i mógł narobić sporo rachunków, zwłaszcza dla deweloperów, którzy muszą wielokrotnie wywoływać model AI przez API dla swoich aplikacji w ciągu dnia.

W rezultacie programiści zaczęli sięgać po tańsze, mniejsze modele sztucznej inteligencji od konkurentów, np. Gemini 1.5 Flash czy Claude 3 Haiku.

Teraz OpenAI wypuszcza GPT-4o mini, swój najbardziej ekonomiczny model, dzięki któremu wkraczają również na rynek małych modeli AI. Chociaż GPT-4o mini jest ich najtańszym modelem, nie osiąga tak niskich kosztów poprzez ograniczenie inteligencji; jest inteligentniejszy niż ich obecny model GPT-3.5 Turbo.

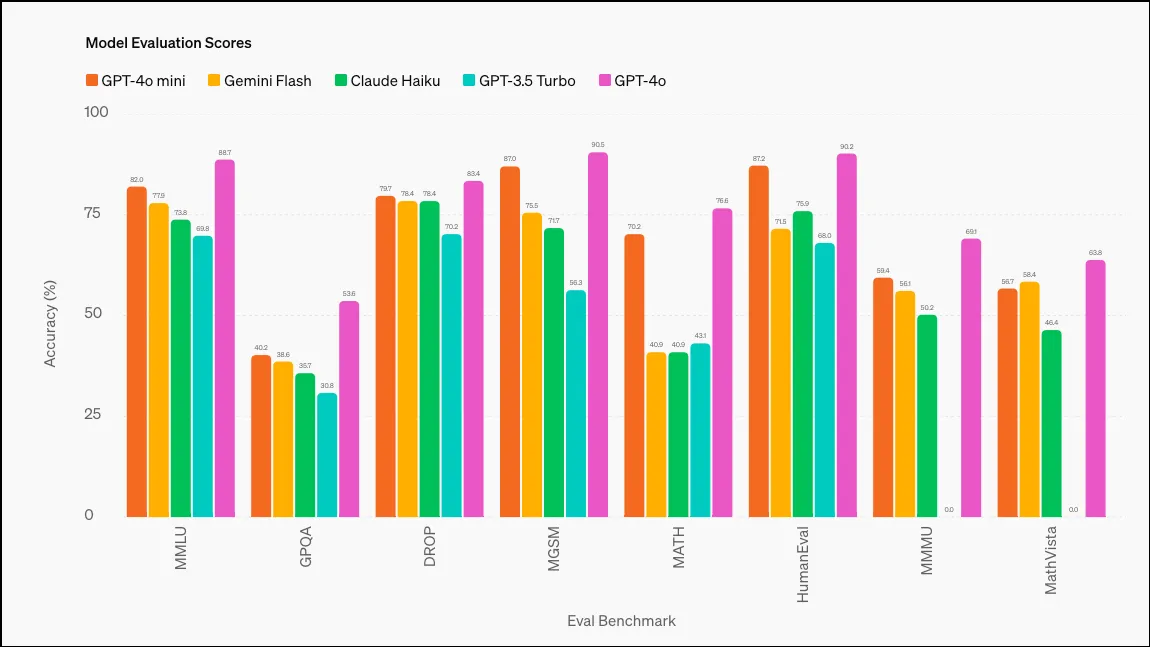

Według OpenAI, GPT-4o mini uzyskał 82% w teście MMLU (Measuring Massive Multitask Language Understanding), przewyższając wiele modeli; oto odpowiednie wyniki różnych modeli: GPT-3.5 Turbo (70%), Claude 3 Haiku (75,2%) i Gemini 1.5 Flash (78,9%). GPT-4o uzyskał 88,7% w tym teście, a Gemini Ultra może pochwalić się najwyższym wynikiem – 90% (choć nie są to małe modele AI).

GPT-4o mini jest dziś udostępniany użytkownikom ChatGPT Free, Team i Plus, a także deweloperom. Dla użytkowników ChatGPT zasadniczo zastąpił GPT-3.5; GPT-4o mini będzie modelem, do którego domyślnie będzie przechodzić konwersacja, gdy skończą się bezpłatne zapytania GPT-4o. Deweloperzy nadal będą mieli możliwość korzystania z GPT-3.5 za pośrednictwem API, ale ostatecznie zostanie ono wycofane. Użytkownicy ChatGPT Enterprise uzyskają dostęp do GPT-4o mini w przyszłym tygodniu.

Jak wspomniano powyżej, celem GPT-4o mini jest pomoc deweloperom w znalezieniu taniego i szybkiego modelu dla ich aplikacji, który jest również zdolny. W porównaniu z innymi małymi modelami, GPT-4o mini wyróżnia się w zadaniach rozumowania zarówno w tekście, jak i w wizji, zadaniach rozumowania matematycznego i kodowania, a także rozumowania multimodalnego.

Obecnie API obsługuje zarówno tekst, jak i obraz, a w planach na przyszłość jest obsługa tekstu, obrazów, wideo i danych wejściowych i wyjściowych audio.

GPT-4o mini ma okno kontekstowe 128 tys. tokenów dla danych wejściowych i 16 tys. tokenów dla danych wyjściowych na żądanie, a jego wiedza sięga października 2023 r. Może również obsługiwać tekst w języku innym niż angielski w sposób dość opłacalny.

Dodaj komentarz