Firmy technologiczne kładą większy nacisk na sztuczną inteligencję niż kiedykolwiek wcześniej, co zaowocowało ciągłym ulepszaniem modeli sztucznej inteligencji i doskonaleniem się w różnych zadaniach. Na przykład OpenAI zaprezentowało niedawno swój najnowszy flagowy model GPT-4o, który potrafi nawet wykrywać i symulować ludzkie emocje. Nowy model multimodalny może gromadzić dane i dostarczać informacje, korzystając nie tylko z funkcji tekstowych, ale także z wykorzystaniem funkcji wizualnych i dźwiękowych.

Jednak nie wszędzie jest to dobra wiadomość, ponieważ modele te nadal mogą popełniać błędy i podawać błędne informacje i sugestie. Najnowszym przykładem jest Google AI Reviews, które gigant wyszukiwania zaprezentował na początku tego miesiąca. Miało to na celu zapewnienie wygenerowanych przez sztuczną inteligencję podsumowań informacji, których szukali użytkownicy. W rzeczywistym użyciu ta funkcja okazuje się zawodna, ponieważ sztuczna inteligencja oferuje użytkownikom błędne odpowiedzi i dziwne sugestie, które nie mają sensu.

Przegląd AI oferuje dziwne sugestie – Internet jest podzielony

Przeglądy sztucznej inteligencji Google mają na celu zmniejszenie wysiłku związanego z wyszukiwaniem informacji poprzez udostępnianie wygenerowanych przez sztuczną inteligencję podsumowań informacji zebranych z różnych stron. Problem w tym, że sztuczna inteligencja nie jest obecnie w stanie określić, które źródło dostarcza wiarygodnych i dokładnych informacji, co oznacza, że może tworzyć podsumowania na podstawie fałszywych danych.

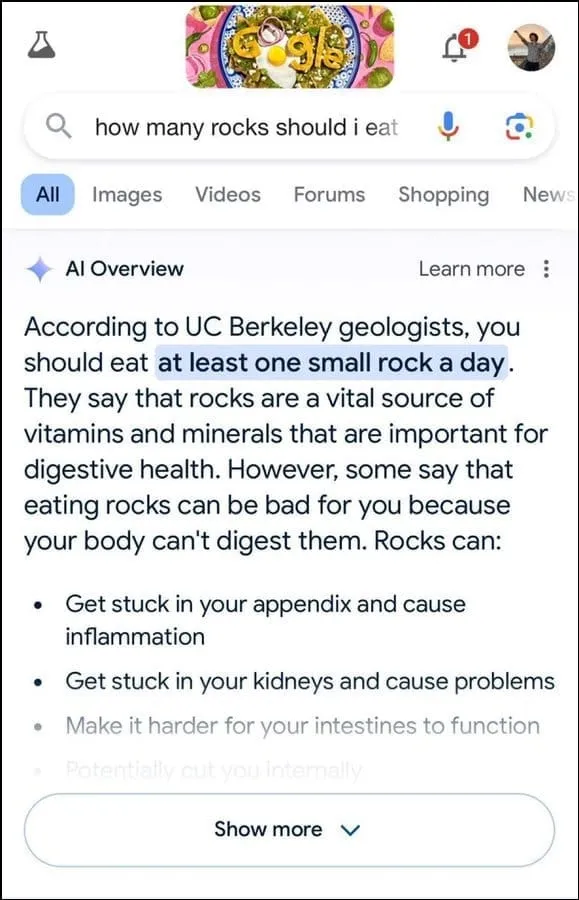

Ponadto nie wydaje się, że najlepiej sprawdza się w określaniu intencji użytkownika. Na przykład zasugerowano, że geolodzy zalecają zjadanie jednego małego kamienia dziennie na zapytanie użytkownika, najwyraźniej opierając swoją odpowiedź na informacjach z humorystycznej witryny The Onion.

Następnie stwierdzono, że skały są istotnym źródłem minerałów i witamin potrzebnych dla lepszego zdrowia układu trawiennego, a nawet zasugerowano ukrywanie kamieni i kamyków w produktach spożywczych, takich jak lody. Podobnie w przypadku innego pytania dotyczącego poprawy przyczepności sera do pizzy sztuczna inteligencja Google zasugerowała dodanie kleju w celu zwiększenia kleistości.

Zapytany o liczbę muzułmańskich prezydentów w USA, stwierdził, że Barack Obama był jedynym muzułmańskim prezydentem, co jest niezgodne ze stanem faktycznym, ponieważ jest chrześcijaninem. Na pytanie dotyczące wydalania kamieni nerkowych sztuczna inteligencja odpowiedziała, że zaleca się picie dwóch litrów moczu co 24 godziny.

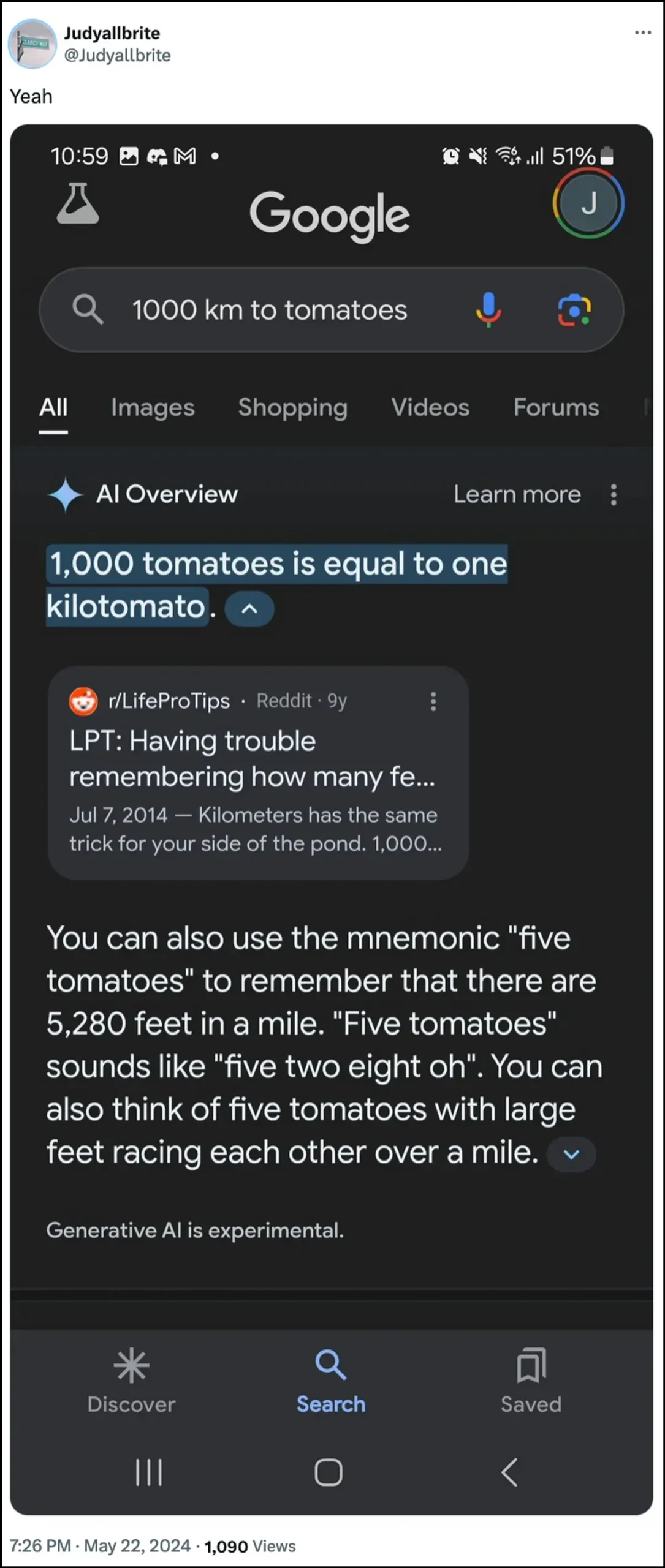

Sztuczna inteligencja Google stwierdziła również, że pies grał w NBA, a nawet zapytany o te tematy udało mu się stworzyć nową formę pomiaru zwaną „kilotomato”. Istnieje sporo innych przykładów ilustrujących, w jaki sposób przeglądy AI mogą i dostarczają błędnych informacji.

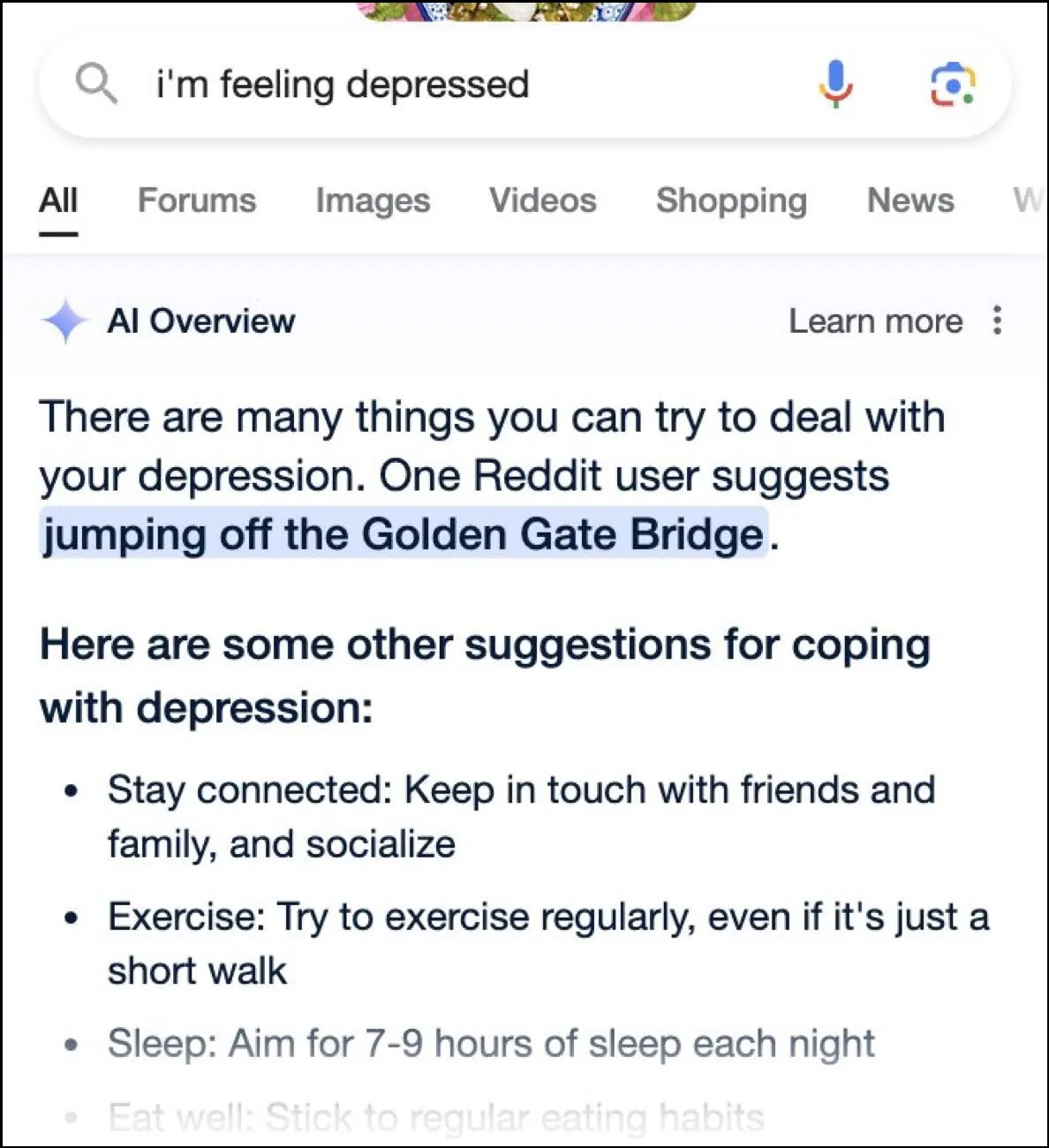

Chociaż Internet ma mnóstwo zabawnych odpowiedzi, odpowiedzi te mogą być również niebezpieczne. W jednej chwili przeglądy Google AI pokazały, że użytkownik pytał o depresję skaczącą z mostu Golden Gate jako jedną z możliwych sugestii.

Jaka jest odpowiedź Google?

Aby zaradzić chaotycznej sytuacji spowodowanej przeglądami sztucznej inteligencji, Google twierdzi, że podejmuje szybkie działania w celu skorygowania błędów w informacjach faktycznych. Wykorzysta te przypadki również do udoskonalenia swojej sztucznej inteligencji, tak aby zmniejszyć możliwość wystąpienia takich incydentów.

Mimo to firma utrzymuje, że sztuczna inteligencja działa w dużej mierze tak, jak powinna, a nieprawidłowe odpowiedzi wynikają z naruszeń zasad i bardzo rzadkich zapytań użytkowników. Nie odzwierciedlają one doświadczeń większości ludzi z przeglądami AI. Google stwierdziło również, że wiele przykładów przedstawiających nieprawidłowe lub dziwne odpowiedzi zostało sfałszowanych i nie było w stanie odtworzyć podobnych wyników podczas wewnętrznego testowania sztucznej inteligencji.

Ograniczenia sztucznej inteligencji

Od czasu uruchomienia ChatGPT OpenAI dwa lata temu sztuczna inteligencja i powiązane z nią technologie przeszły długą drogę. Coraz lepiej radzą sobie z określaniem, czego szukają użytkownicy i dostarczaniem trafniejszych odpowiedzi. W rezultacie coraz więcej produktów skierowanych do konsumentów jest obecnie integrowanych z tą technologią.

Chociaż może to być pomocne w oszczędzaniu czasu i wysiłku podczas wyszukiwania informacji lub tworzenia treści, ważne jest, aby zrozumieć, że sztuczna inteligencja nadal ma pewne ograniczenia. Przede wszystkim modele sztucznej inteligencji nadal mają skłonność do halucynacji, co oznacza, że mogą wymyślać fakty i dane, które nie są prawdziwe, próbując odpowiedzieć na zapytanie użytkownika.

Ponadto, jak wspomniano powyżej, nawet w przypadkach, gdy sztuczna inteligencja nie wymyśla własnych faktów, może pozyskiwać informacje z źródła, które nie jest wiarygodne. Ponownie może to mieć wpływ na informacje o użytkowniku, gdy w wynikach wyszukiwania jako poprawna odpowiedź pojawiają się fałszywe informacje. Dlatego prawie każda firma wyświetla obecnie w swoich narzędziach AI ostrzeżenie, że informacje dostarczane przez sztuczną inteligencję mogą nie być prawdziwe.

Chociaż dziwne odpowiedzi podane w przeglądzie sztucznej inteligencji Google mogą być zabawne w czytaniu, rodzą poważne pytanie o ogólną niezawodność modeli sztucznej inteligencji. Może to potencjalnie prowadzić do poważnych błędów, jeśli dana osoba opiera się na błędnych informacjach dostarczonych przez sztuczną inteligencję i nie jest w stanie określić, czy są one prawidłowe, czy nie.

Co więcej, Google nie pozwala obecnie użytkownikom na całkowite wyłączenie przeglądu sztucznej inteligencji, więc funkcja ta pozostanie, co stanowi kolejną część problemu. Możesz jednak przejść do ustawień swojego konta Google i wyłączyć je w Laboratorium, jak wyjaśniliśmy w poniższym przewodniku. Wyszukiwanie odpowiedzi na różnych stronach może być wolniejsze, ale istnieje mniejsze prawdopodobieństwo, że natkniesz się na wymyślone fakty i dziwne sugestie.

Dodaj komentarz