Podczas gdy wiele przeglądarek integruje w swoich przeglądarkach funkcje sztucznej inteligencji, Opera właśnie stała się pierwszą przeglądarką, która integruje lokalne modele sztucznej inteligencji. Opera dodaje eksperymentalną obsługę ponad 150 wariantów lokalnego modelu dużego języka (LLM) z około 50 różnych rodzin modeli do swojej przeglądarki Opera One.

Ponieważ modele językowe będą lokalne, użytkownicy nie będą musieli się martwić, że ich dane zostaną przesłane na serwer LLM. To prywatny i bezpieczny sposób korzystania ze sztucznej inteligencji.

Aby korzystać z lokalnych modeli LLM, będziesz potrzebować 2-10 GB miejsca na swoim komputerze, w zależności od wariantu, z którego będziesz korzystać. Niektóre z obsługiwanych LLM obejmują Llama od Meta, Phi-2 od Microsoft, Gemma od Google, Vicuna, Mixtral od Mistral AI itp. Możesz używać tych modeli językowych zamiast Aria AI z Opery i przełączać się z powrotem na Aria AI za każdym razem, gdy chcieć.

Ta funkcja jest obecnie dostępna tylko w wersji deweloperskiej Opery One. Oto, jak aktywować i używać lokalnych modeli AI w Opera One Developer.

Pobierz programistę Opera One

Jeśli masz już programistę Opera One, po prostu pomiń tę sekcję i przejdź od razu do korzystania z lokalnych modeli LLM.

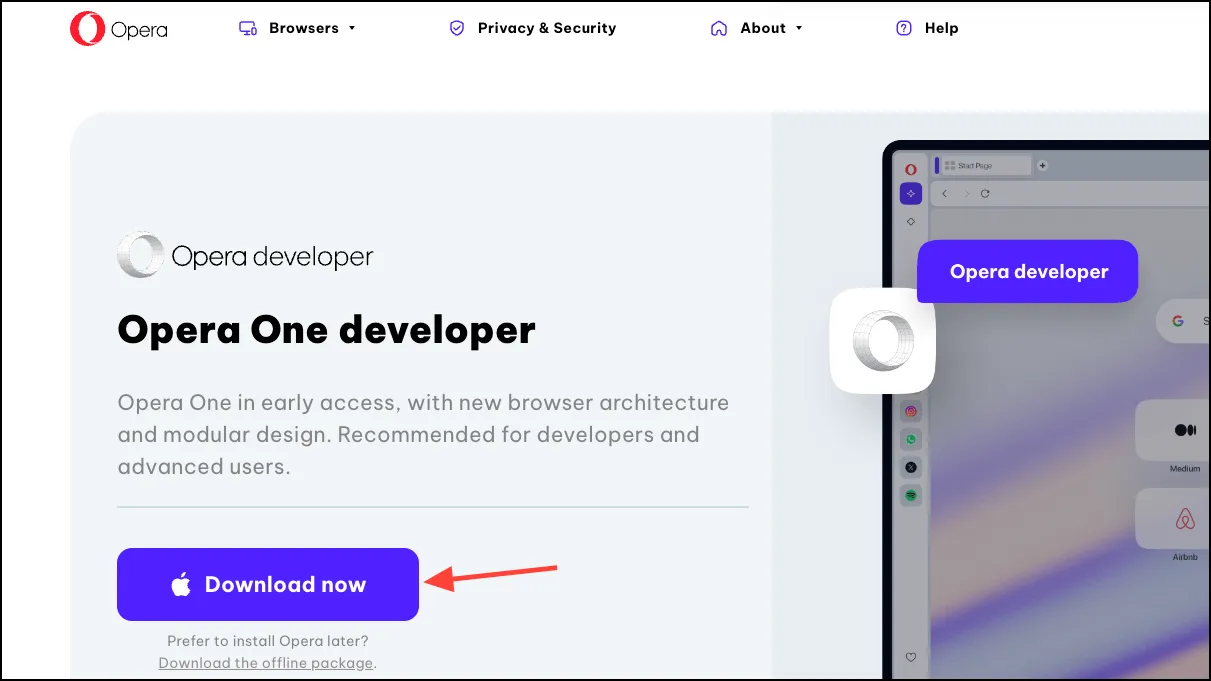

- Kliknij ten link, aby pobrać program Opera One Developer. Przewiń w dół i kliknij „Pobierz teraz” na kafelku Opera One Developer.

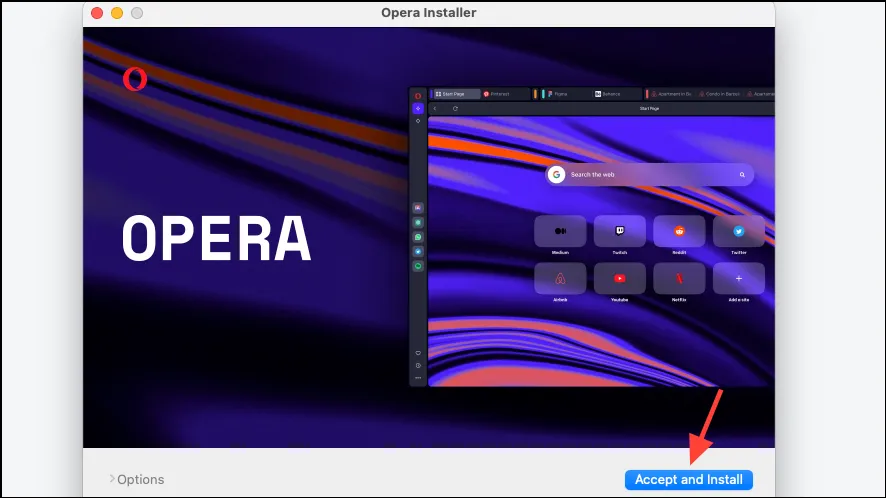

- Po pobraniu otwórz plik i uruchom instalator.

- Kliknij „Zaakceptuj i zainstaluj”, a następnie postępuj zgodnie z instrukcjami wyświetlanymi na ekranie, aby zainstalować przeglądarkę.

Skonfiguruj lokalny model AI

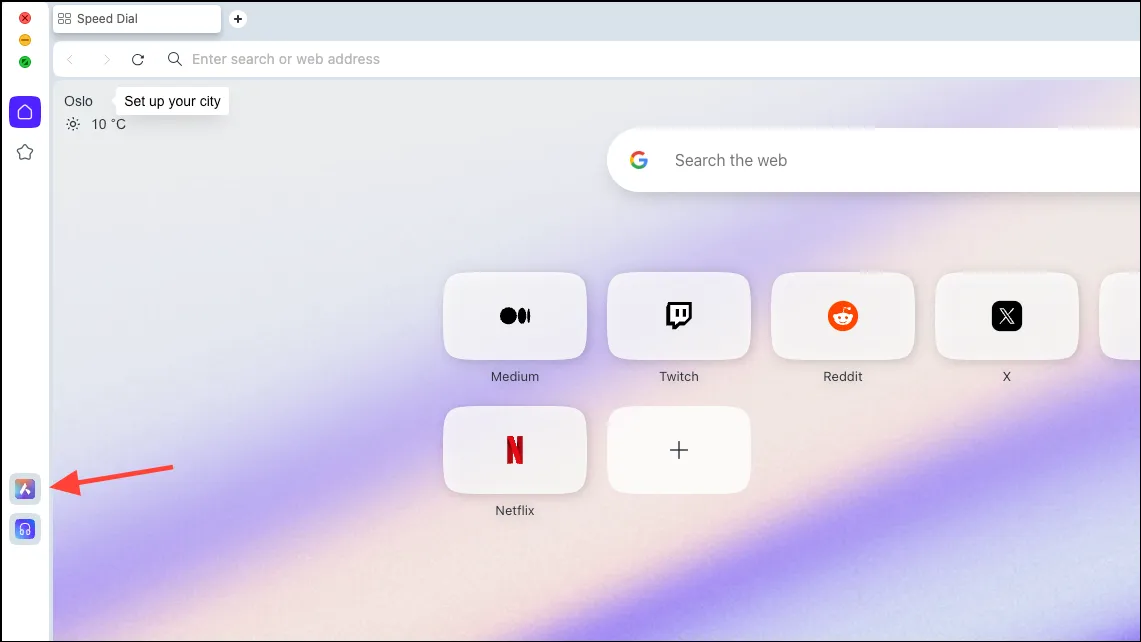

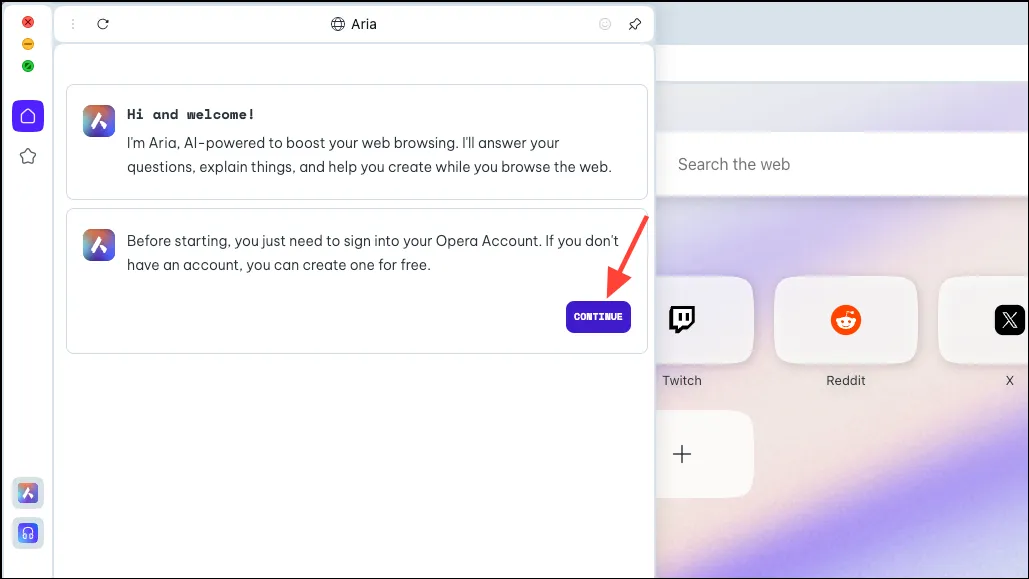

- Po pobraniu przeglądarki kliknij ikonę „Aria AI” na lewym pasku bocznym.

- Kliknij „Kontynuuj”, aby kontynuować.

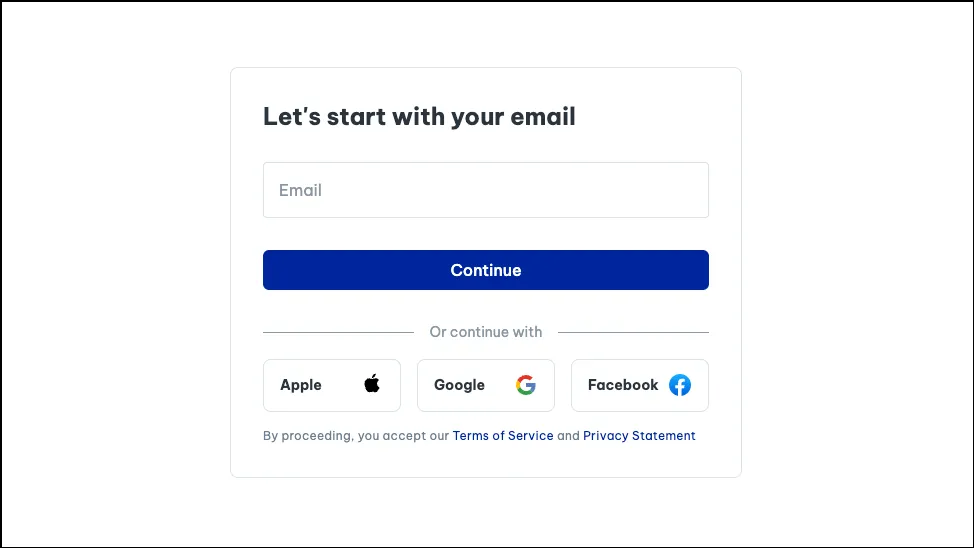

- Jeśli korzystasz z Arii po raz pierwszy, aby móc z niej korzystać, musisz założyć bezpłatne konto Opery. Do utworzenia konta Opery możesz użyć swojego adresu e-mail lub konta Apple, Facebook lub Google.

- Po utworzeniu konta będziesz mógł rozmawiać z Arią.

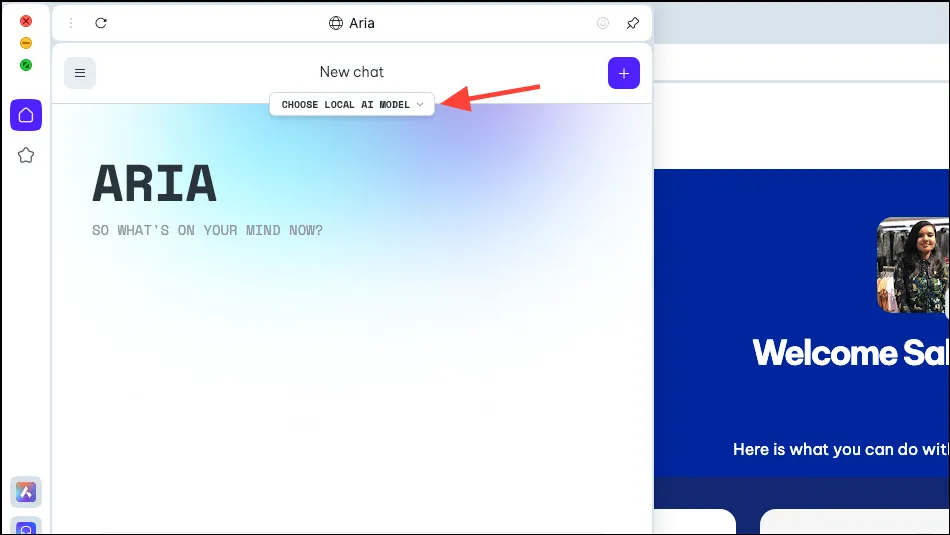

- Teraz w panelu Aria zobaczysz opcję „Wybierz lokalny model AI”. Kliknij na to.

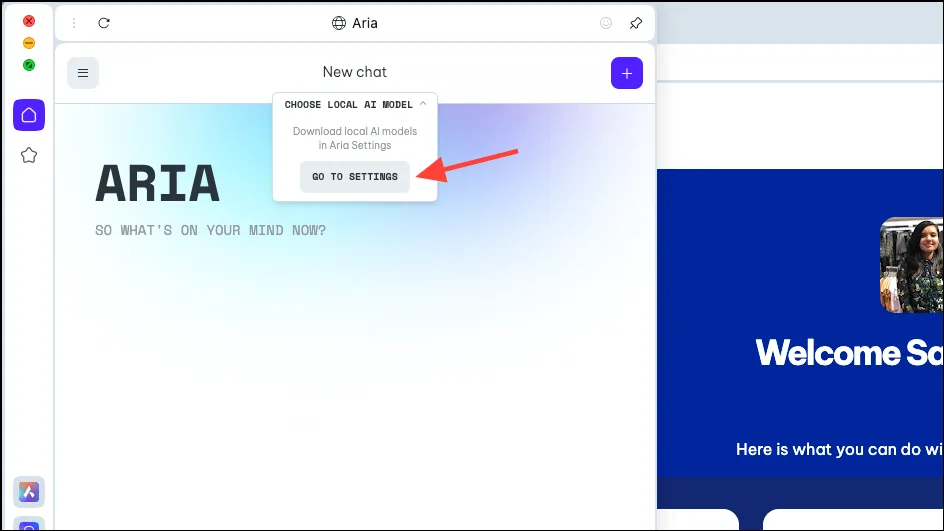

- Z menu rozwijanego wybierz opcję „Przejdź do ustawień”.

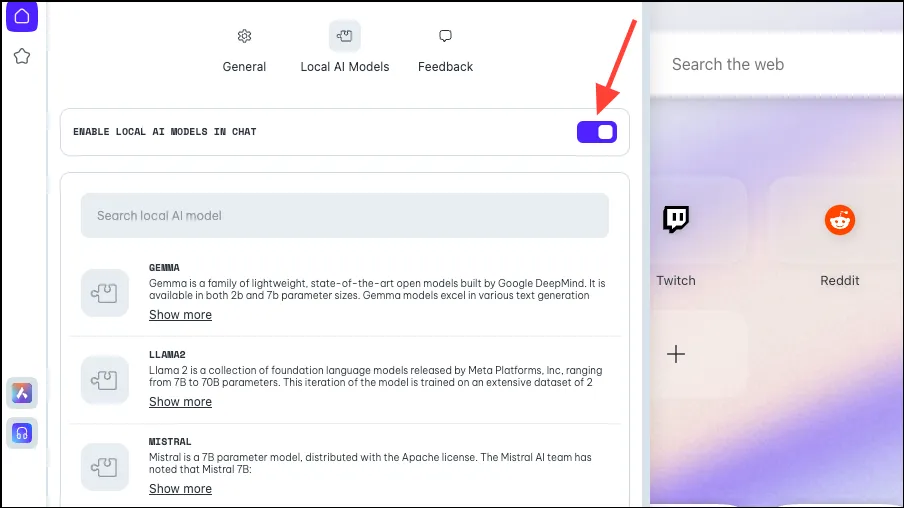

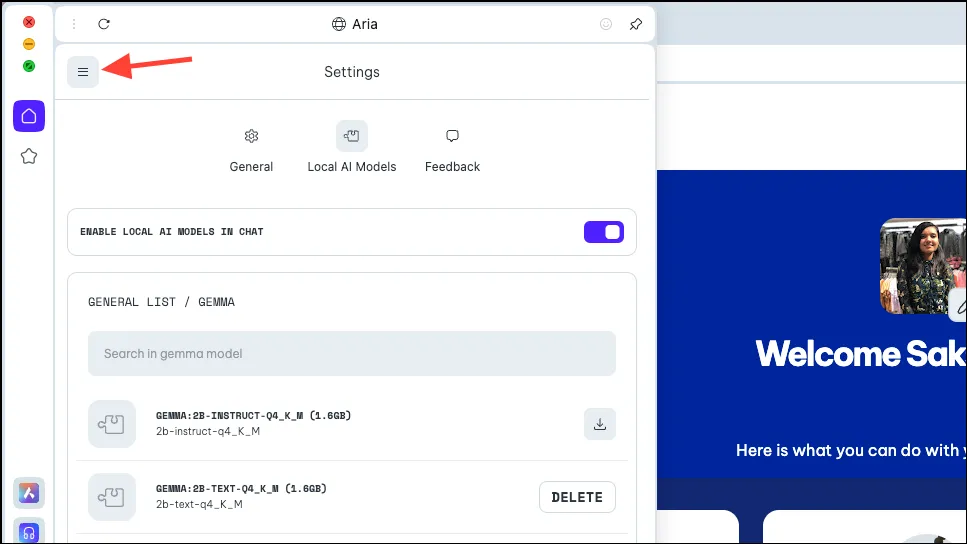

- Upewnij się, że przełącznik „Włącz lokalną sztuczną inteligencję w czatach” jest włączony.

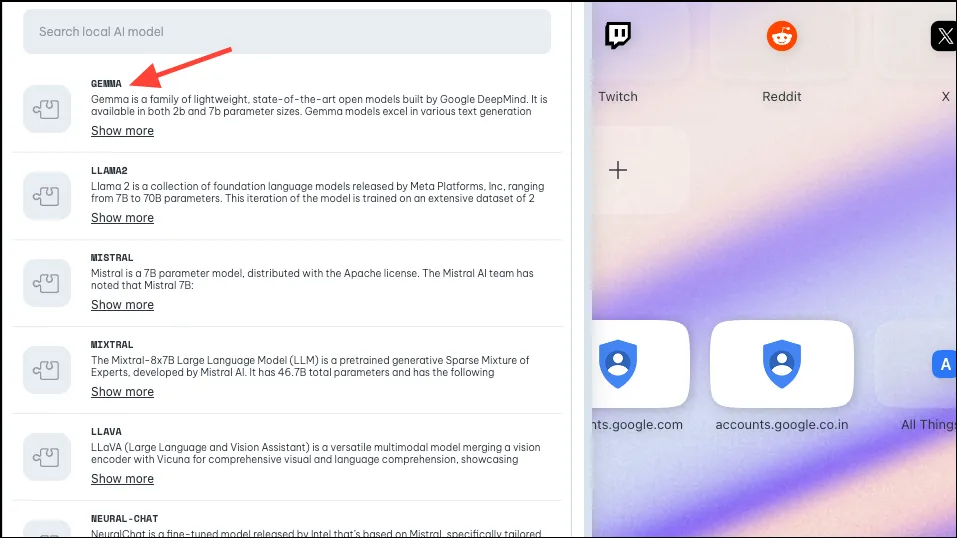

- Następnie wybierz model, który chcesz pobrać do użytku lokalnego, klikając go lub wyszukując. Jak wspomniano powyżej, Opera wdrożyła obsługę około 50 rodzin modeli w różnych wariantach, co daje w sumie 150.

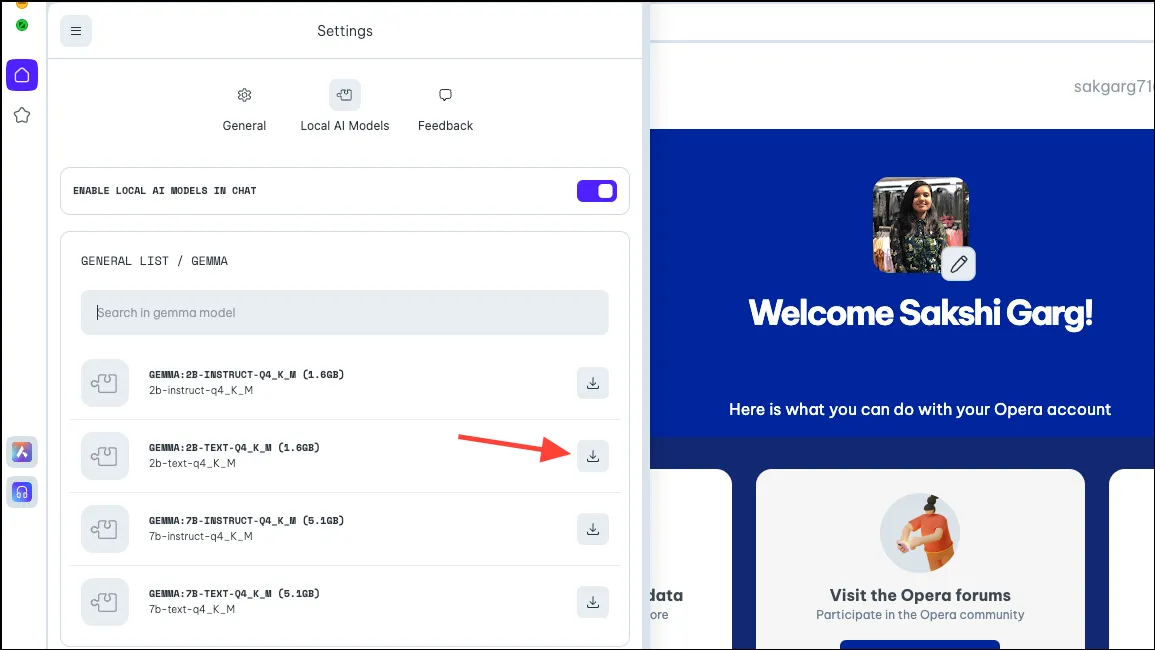

- Tak więc w przypadku niektórych modeli po kliknięciu niektórych modeli, np. Google Gemma, otrzymasz 4 różne warianty. Pobierz model, którego chcesz użyć. Na potrzeby tego przewodnika pobieramy model 2B Text firmy Gemma. Kliknij przycisk „Pobierz” po prawej stronie. Przed pobraniem możesz sprawdzić ilość miejsca wymaganą przez model na komputerze.

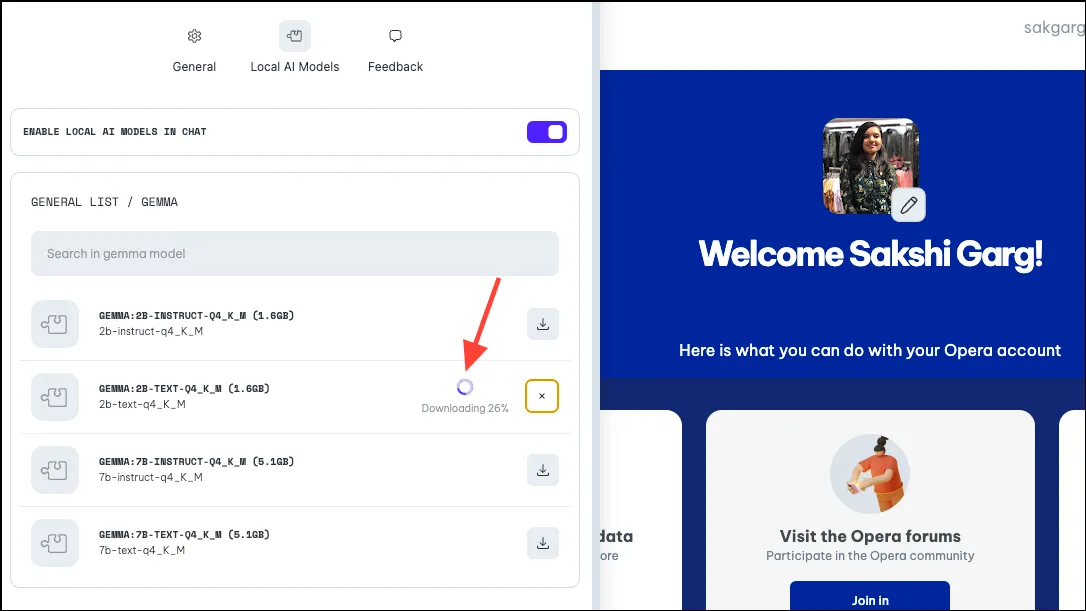

- Pobieranie może zająć trochę czasu, w zależności od rozmiaru modelu i połączenia internetowego. Obok możesz zobaczyć postęp pobierania.

Korzystanie z lokalnego modelu AI

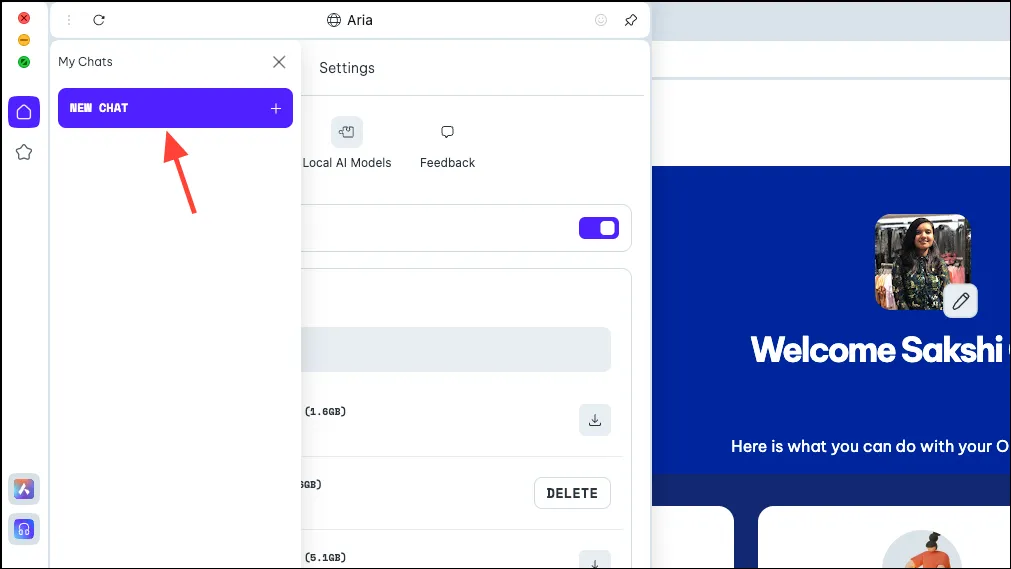

- Po pobraniu modelu kliknij ikonę „Menu” w lewym górnym rogu panelu.

- Z wyświetlonego menu wybierz „Nowy czat”.

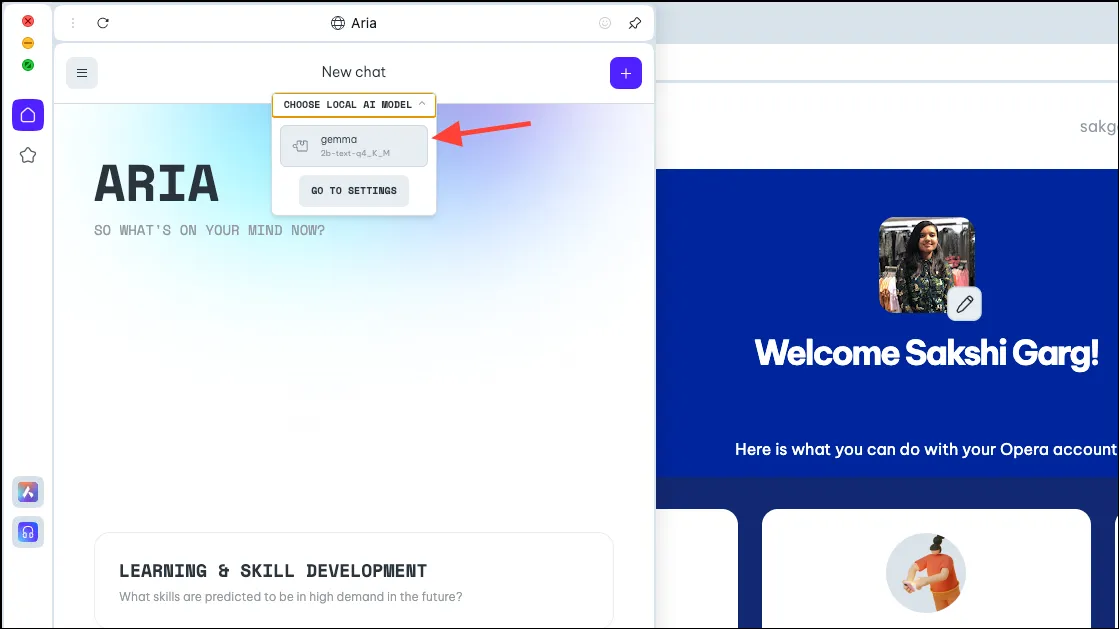

- Ponownie kliknij opcję „Wybierz lokalny model AI” u góry i wybierz z menu rozwijanego właśnie pobrany model, w naszym przypadku Gemmę.

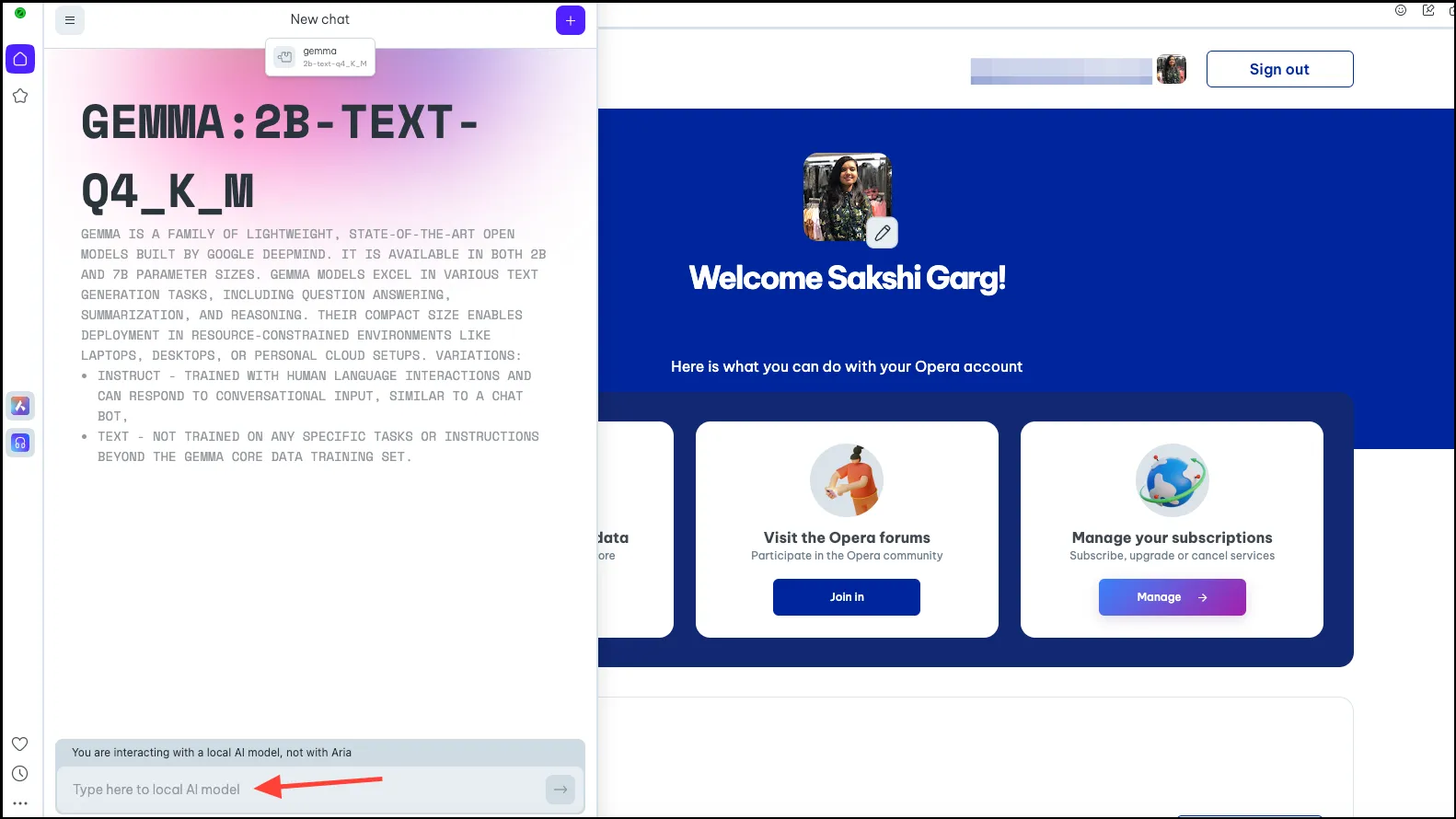

- Zostaniesz teraz przełączony na wybrany lokalny model AI. Wpisz monit w pasku podpowiedzi i wyślij go do sztucznej inteligencji, aby rozpocząć lokalne interakcje.

- Twoje czaty z modelem Local AI będą dostępne w historii czatów, tak samo jak Twoje czaty z Arią. Możesz także zmienić nazwę czatów, aby zapewnić lepszą organizację.

- Podobnie możesz pobrać i używać wielu lokalnych modeli AI, ale pamiętaj, że każdy wymaga od 2 do 10 GB miejsca na komputerze.

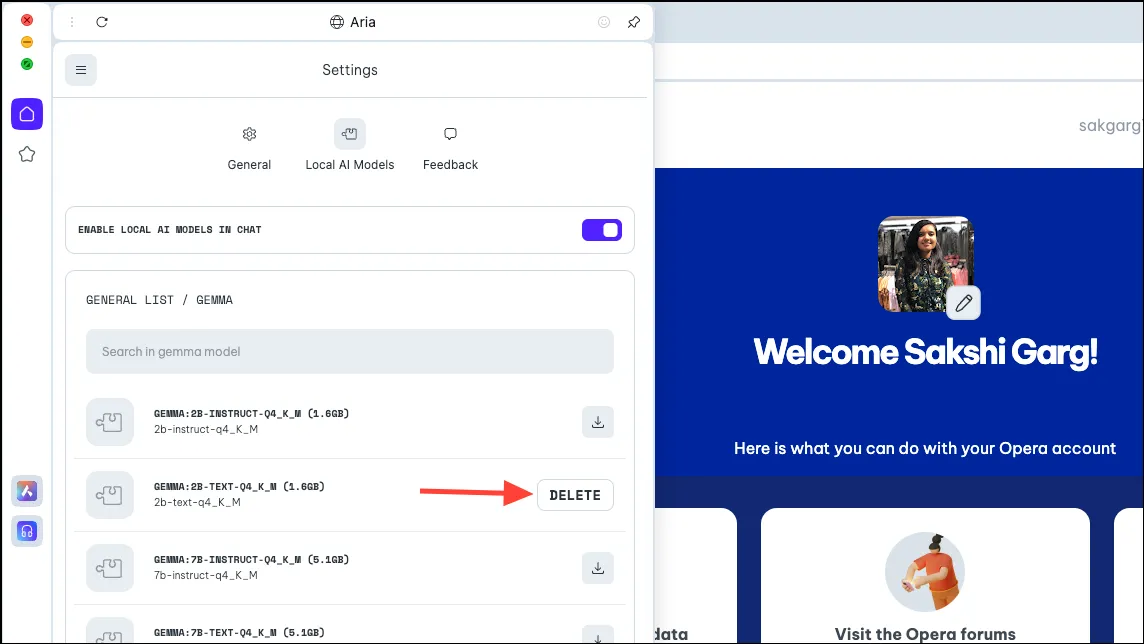

- Aby usunąć model z komputera, przejdź do tych samych ustawień, z których wcześniej pobraliśmy model, tj.

Aria>Settings>Local AI Models>[Downloaded Model]. Następnie kliknij przycisk „Usuń”.

Wróć do Arii

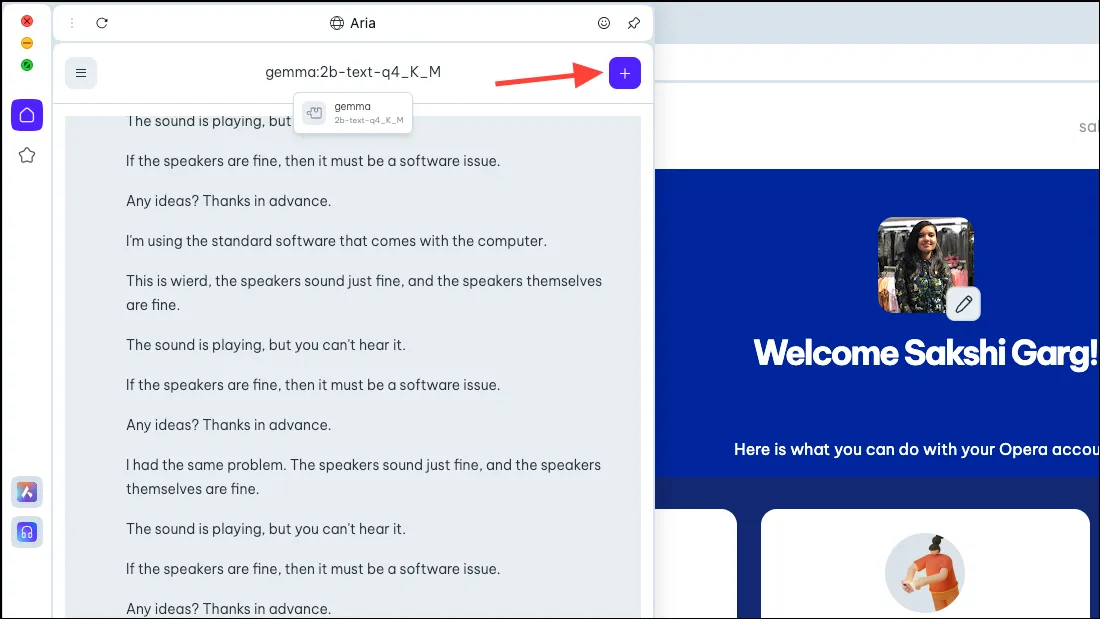

- Aby wrócić do Arii, po prostu rozpocznij nowy czat z AI. Kliknij ikonę „+” w prawym górnym rogu.

- Nowy czat rozpocznie się od samej Arii.

Możliwość korzystania z lokalnych modeli sztucznej inteligencji w przeglądarce Opera One jest bardzo ekscytująca, i to nie tylko z punktu widzenia bezpieczeństwa i prywatności. Choć na wczesnym etapie wszystko jest bardzo proste, potencjalne przyszłe przypadki są dość ekscytujące. Przeglądarka z lokalną sztuczną inteligencją może oznaczać, że może wykorzystywać Twoje dane historyczne do wszystkich Twoich danych; jakie to byłoby ekscytujące! Zespół Opery bada taką możliwość.

Jednak nawet bez przyszłych możliwości lokalne AI są świetnym posunięciem dla użytkowników, którzy martwią się o swoje dane i czaty z AI przechowywane na jej serwerach. Istnieje kilka świetnych kursów LLM, które możesz eksplorować, takich jak Lama do kodowania, Phi-2 do wyjątkowych zdolności rozumowania i Mixtral do zadań takich jak generowanie tekstu, odpowiadanie na pytania itp.

Dodaj komentarz